Введем обозначение I для количества информации и Vд для объема данных.

Синтаксическая мера оперирует обезличенной информацией, не выражающей смыслового отношения к объекту (данными).

Объем данных Vд в сообщении измеряют количеством разрядов. Один разряд в каждой системе счисления имеет различный вес и обозначает соответствующую единицу измерения данных (бит в двоичной, байт в восьмеричной, дит в десятичной), например, сообщение в 2-й с.с. в виде кода 10111011 (восемь разрядов) имеет объем в 8 бит. На данном уровне количество информации рассматривают в соответствии с неопределенностью состояния системы (энтропией). Это связано с неосведомленностью получателя о состоянии системы. Сведения потребителя о системе обозначим за a. Мера неосведомленности о системе является функцией H(a), что является мерой неопределенности состояния системы. При получении сообщения b, получатель приобрел дополнительную информацию Ib(a), что уменьшило его неосведомленность и тем самым, снизило неопределенность состояния системы до Hb(a). В итоге количество информации можно определить по формуле: Ib(a) = H(a) - Hb(a).

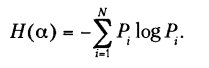

Количество информации измеряют как изменение неопределенности состояния системы. Если неопределенность Hb(a) станет нулевой, то первоначальное знание о системе станет полным, т. е. энтропия системы H(a) рассматривается как мера недостающей информации. По формуле Шеннона, энтропия системы, имеющей N возможных состояний, равна:

Pi - вероятность нахождения системы в i-м состоянии. В случае, когда все состояния системы равновероятны, т. е. вероятности равны:

энтропия определяется соотношением:

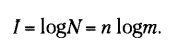

Информацию кодируют числовыми кодами в определенной системе счисления, причем в разных системах счисления, одно количество разрядов передает разное количество состояний:

Где N - количество состояний (количество возможных кодовых комбинаций); m - основание системы счисления; n - количество разрядов в сообщении.

Количество приобретенной получателем сообщения информации для равновероятностных систем (система может с равной вероятностью находится в любом из возможных состояний) определяется формулой Хартли:

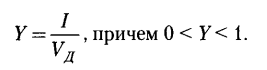

Если в основании логарифма m, то I = n, что означает равенство количества полученной информации объему данных (при условии полного априорного незнания получателем содержания сообщения), полученных по каналу связи (I=Vд). Для неравновероятных состояний системы I<Vд = n. Коэффициент информативности сообщения определяют как отношения количества информации к объему данных:

С увеличением коэффициента информативности снижается объем работы по преобразованию информации (данных) в системе.

Семантическая мера (смысл) количества информации наиболее часто используемая - это тезаурусная мера, связывающая семантические свойства информации со способностью пользователя принимать поступившее сообщение.

Тезаурус (Sp) - совокупность сведений, которыми располагает пользователь или система.

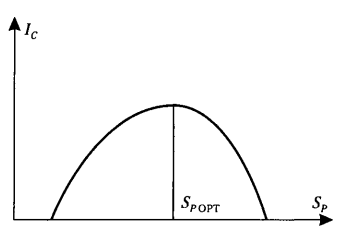

Измеряют количество семантической информации Ip, воспринимаемой пользователем и включаемой им в свой тезаурус в зависимости от соотношения между смысловым содержанием S и тезаурусом пользователя Sp. Характер зависимости имеет вид нормального распределения:

Sp -> 0 пользователь не поспринимает и не понимает информацию;

Sp -> Inf пользователь все знает и поступающая информация не нужна.

Зависимость количества информации, воспринимаемой пользователем, от его тезауруса:

При согласовании смыслового содержания S со своим тезаурусом Sp (Sp=Sopt) пользователь получает максимальное количество семантической информации Ic, т.е. поступающая информация не известна пользователю и предельно понятна ему. Количество семантической информации является величиной знаний и относительно.

Семантический шум - бессмысленное сообщение по своему смысловому содержанию для пользователя в виду различных причин (уровня компетенции и т.п.). Количество семантической информации относительно и зависит от пользователя. Следует стремится к согласованию S и Sp. Относительно мерой количества семантической информации может служить коэффициент содержательности С:

Прагматическая мера определяет ценность информации для достижения поставленной пользователем цели. Величина относительна, и обусловлена особенностями применения информации. Ценность информации целесообразно измерять в единицах целевой функции (зависит от системы применения). В экономической системе прагматические свойства информации (ценность) определяют приростом экономического эффекта функционирования, достигнутым благодаря использованию информации для управления системой.

Иногда выделяют структурный класс информационных мер:

- адаптивная мера (мера Хартли);

- геометрическая мера - измерение параметра геометрической модели информационного сообщения (длины, площади, объема) в дискретных единицах. Максимально возможное количество информации в заданных структурах определяет информационную емкость модели (систему), которую описывают как сумму дискретных значений по всем измерениям.

- комбинаторная мера - количество информации определяется как число комбинаций элементов (символов). Возможное количество информации совпадает с числом возможных сочетаний, перестановок или размещений элементов.

| Сводная таблица |

|---|

| Мера информации | Единицы измерения | Пример |

|---|---|---|

| Синтаксическая | Степень уменьшения неопределенности (Шеннон) | Вероятность события |

| Единицы представления инфомрации (ЭВМ) | Бит, байт ... | |

| Семантическая | Тезаурус | Программное обеспечение, ЭВМ и т.д. |

| Экономические показатели | Рентабельность, производительность, коэффициент амортизации и т.д. | |

| Прагматическая | Ценность использования | Емкость памяти, производительность компьютера, скорость передачи данных, время обработки информации и принятия решения |